티스토리 뷰

폴더에서 hdfs로 이동

로컬폴더 -> hdfs

-

설정파일 생성

-

설정

-

flume 실행

-

input 데이터 추가

-

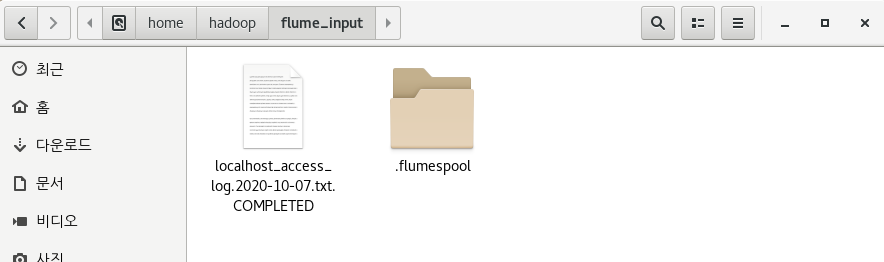

확인

-

결과

로컬폴더 -> hdfs (세부 설정 추가)

-

설정파일 생성

-

설정

-

flume 실행

-

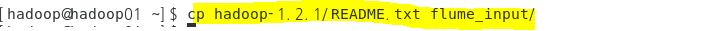

input 데이터 추가

-

확인

-

결과

shell 실행 명령어를 이용해서 hdfs에 적재

-

설정

-

command -> flume_input 안의 README.txt 파일 읽기

-

flume 실행

-

input 데이터 추가

-

확인

-

shell명령어를 통해 실행하면 COMPLETED가 생기지 않음

was의 로그파일이 저장되는 위치에서 hadoop의 hdfs로 이동

hadoop02머신에 tomcat 설치

-

다운로드

-

압축 풀기

-

tomcat 설정

-

/home/hadoop/.bashrc

-

설정파일 적용

-

톰캣 실행

-

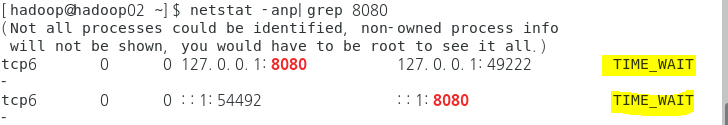

네트워크 확인

-

LISTEN : 실행중

-

톰캣 종료

-

네트워크 확인

-

외부에서 접속하기 위해서 db세팅 IP주소로 변경

-

톰캣 유저 파일 설정

-

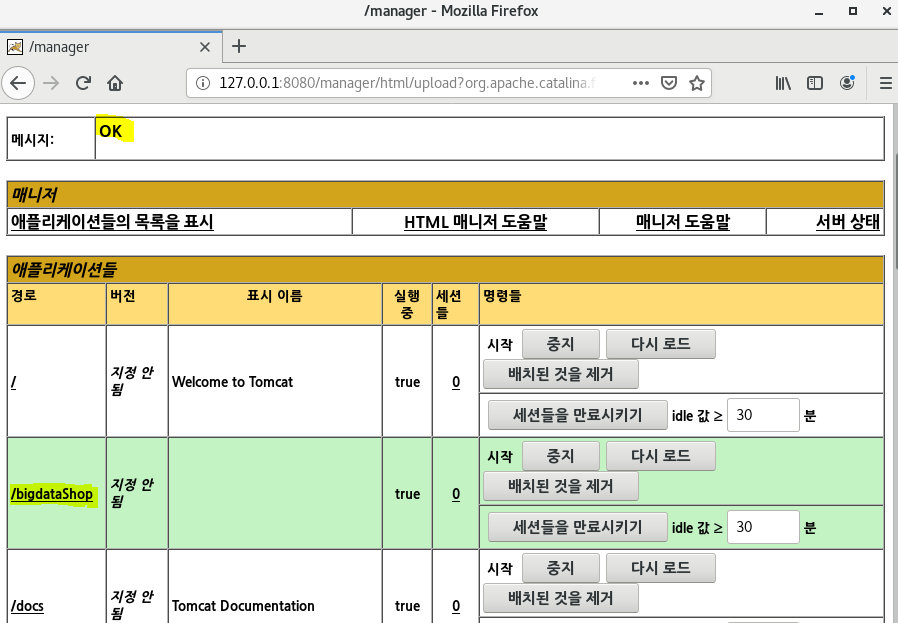

Tomcat 웹 어플리케이션 매니저 접속

-

프로젝트 export

-

hadoop02 머신 홈 디렉토리로 복사

-

Tomcat에 등록

-

윈도우에서 hadoop02의 tomcat 서버로 접속

-

hadoop02의 flume 설정파일 생성

-

hadoop02에서는 폴더에서 log파일을 가져와서 hadoop01로 넘겨준다.

-

source = spoolDir

-

sink = avro

-

hadoop01로 데이터를 보내야 하므로 hadoop01의 ip가 필요하다

-

hadoop01의 flume 설정파일 생성

-

hadoop01에서는 hadoop02에서 받은 파일을 hdfs로 적재

-

source = avro

-

sink = hdfs

-

hadoop02의 요청을 받을수 있도록 ip 와 port 를 설정한다.

-

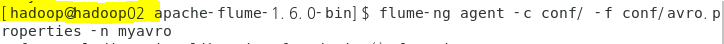

flume으로 데이터를 주고받기 위해 양쪽 모두 flume이 실행중이어야 한다.

-

hadoop02 에서 지정한 폴더에 로그 데이터 복사

-

확인

'Hadoop' 카테고리의 다른 글

| 빅데이터 플랫폼 구축 #15 - 커스터마이징(2) : 보조정렬 (0) | 2020.10.21 |

|---|---|

| 빅데이터 플랫폼 구축 #14 - 커스터마이징(1) : Combiner (0) | 2020.10.18 |

| 빅데이터 플랫폼 구축 #12 - Flume (1) (0) | 2020.10.10 |

| 빅데이터 플랫폼 구축 #11 - Sqoop (0) | 2020.10.10 |

| 빅데이터 플랫폼 구축 #10 - Mapreduce : 다중 값 출력 (0) | 2020.10.07 |

- Total

- Today

- Yesterday

- hadoop

- springboot

- oracle

- I/O Services of OS

- aop

- Disk System

- jdbc

- Replacement Strategies

- JSON

- Java

- SPARK

- maven

- I/O Mechanisms

- 빅데이터

- RAID Architecture

- Free space management

- Spring

- Allocation methods

- SQL

- Disk Scheduling

- Variable allocation

- File Protection

- Flume

- mapreduce

- linux

- 빅데이터 플랫폼

- HDFS

- gradle

- 하둡

- vmware

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |