티스토리 뷰

- 로그 데이터 수집 툴 (전처리 된 데이터)

-

Source : 외부 이벤트가 생성되어 수집되는 영역

-

Sink : 수집된 로그/이벤트를 목적지에 전달

-

Channel : Source 와 Sink 간의 버퍼구간

채널별로 1개 Sink 지정

-

다른 컴퓨터의 데이터도 수집 가능

-

다운로드

-

압축풀기, 폴더이름 변경

-

환경변수 설정

-

설정변경시 재부팅을 해야함

-

현재 터미널 임시 적용

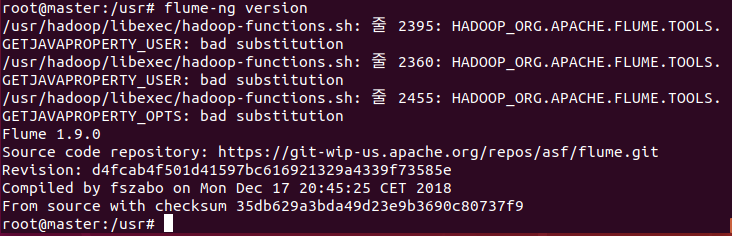

설치확인

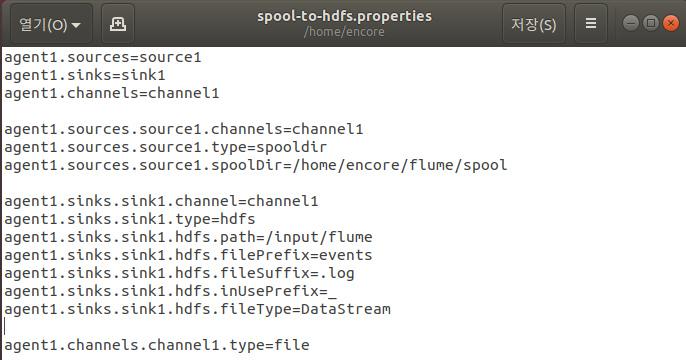

설정

-

agent1 : 최상위 에이전트 명. 단일 에이전트

-

source1 : 에이전트에서 실행된 소스의 이름을 나열. 단일소스

-

spooldir : 새로운 파일의 전송을 위해 스풀링 디렉터리를 검사하는 스플링 디렉터리 소스

-

spoolDir : 스풀링 디렉터리 소스를 지정

-

logger : 콘솔에 이벤트를 기록하는 로거 싱커

-

channel1 : 싱크는 반드시 채널과 연결해야 한다. 파일 채널을 사용하면 파일로 저장

-

스풀링 디렉터리 생성

-

실행

-

새터미널 실행

-

flume 실행 중 스풀링 디렉터리에 파일을 넣으면 자동으로 이벤트 목적지로 이동

-

실행 확인

-

작업이 완료되면 파일이름뒤에 COMPLETED가 붙음

-

HDFS Sink

-

설정 추가 (수집된 로그/이벤트를 지정한 하둡폴더로 이동)

-

하둡 폴더 생성

-

실행

-

결과 확인

-

분기

-

하나의 소스에서 발생한 이벤트를 여러 개의 채널로 전송

-

폴더 생성

-

server 실행 (agent2)

-

새 터미널에서 client 실행 (agent1)

-

새 터미널에서 실행

-

worker 에서 실행

-

Flume 설치

-

환경변수 설정

-

변경 임시 적용

-

권한 설정

설정

-

폴더 생성 , 권한 설정

-

실행

-

실행 확인

'Hadoop' 카테고리의 다른 글

| Pig (0) | 2020.08.19 |

|---|---|

| Sqoop (0) | 2020.08.15 |

| Hadoop - Multi Node Cluster (0) | 2020.08.13 |

| Hadoop - Single Node, Single Node Cluster (0) | 2020.08.13 |

| Oracle 설치 (0) | 2020.08.11 |

- Total

- Today

- Yesterday

- I/O Mechanisms

- Free space management

- Spring

- 빅데이터

- mapreduce

- 하둡

- vmware

- Java

- Replacement Strategies

- HDFS

- I/O Services of OS

- JSON

- Allocation methods

- aop

- jdbc

- oracle

- Flume

- RAID Architecture

- maven

- File Protection

- gradle

- Variable allocation

- Disk Scheduling

- SPARK

- Disk System

- SQL

- hadoop

- 빅데이터 플랫폼

- springboot

- linux

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |