티스토리 뷰

java 설치

-

hadoop은 java로 만들어져 있으므로 java를 설치 해야한다

-

rpm -> 설치 버전

-

tar.gz -> 압축 버전

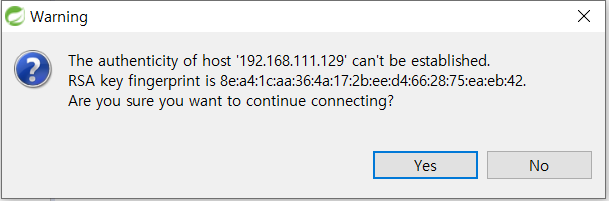

sts 에서 윈도우 -> hadoop01 머신 파일 전송

-

local에 있는 파일을 hadoop01로 전송할 수 있다.

-

윈도우에서 받은 jdk를 hadoop폴더로 전송

-

파일 전송 확인

-

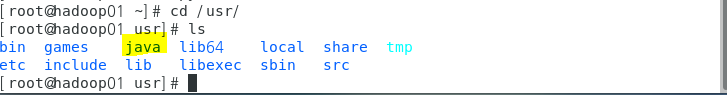

rpm 파일 설치

-

rpm 으로 설치하는 프로그램은 usr폴더에 설치된다.

-

hadoop02, hadoop03, hadoop04로 jdk 파일 복사

-

hadoop02, hadoop03, hadoop04로 jdk 파일 설치

-

root계정의 home디렉토리는 root폴더이므로 경로를 지정하지 앟아도 rpm명령어를 바로 실행 할 수 있다.

Hadoop

-

설치 - hadoop01 머신에서 설치

-

hadoop계정으로 파일 복사

-

확인

-

압축 풀기

-

hadoop02, hadoop03, hadoop04 머신에 복사

-

hadoop02, hadoop03, hadoop04 머신에 설치

-

hadoop 설정

-

masters 설정

-

slaves 설정

-

임시 폴더 생성

-

gedit로 core-site.xml 설정

-

네임노드, 임시폴더 지정

-

hdfs-sith.xml 설정

-

dfs.replication : 복제본의 개수

-

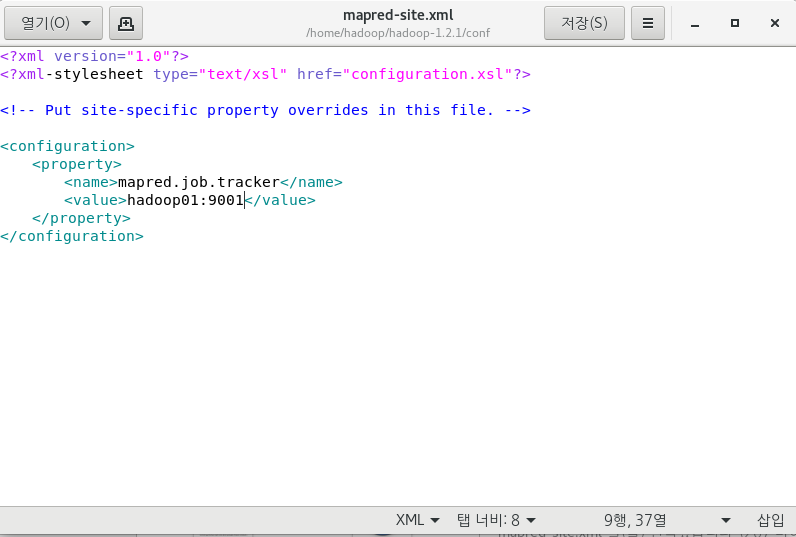

mapred-site.xml 설정

-

설정 파일을 hadoop02, hadoop03, hadoop04에 복사

-

복사 확인

-

네임노드 포맷

-

하둡 실행

-

실행확인

hadoop start 된 후 jps로 확인시 데몬이 모두 실행되어 있지 않은 경우

-

하둡폴더의 logs폴더에서 오류 확인

-

-

오류 수정

-

1번 ~ 4번 머신의 모든 tmp디렉토리를 삭제(hadoop-data폴더)

-

tmp디렉토리 재생성

-

conf폴더의 모든 파일을 4개의 머신에 복사

-

네임노드 초기화

-

hadoop start

-

jps로 데몬 확인

-

-

나머지 머신 노드 확인

-

DataNode에 블록 단위로 분산 저장되므로 로컬에서는 데이터를 확인 할 수없다.

-

NameNode의 관리자 페이지 : hadoop01:50070

-

Live Nodes 현재 실행되고 있는 노드 개수

-

파일 정보 확인 가능

-

hdfs 내 폴더 생성

-

확인

-

hdfs폴더로 파일 복사

-

-put 또는 -copyFromLocal 명령어 사용

hadoop 명령어

-

namenode

-

jar

hdfs 명령어

-

mkdir

-

ls

-

copyFromLocal

-

cat

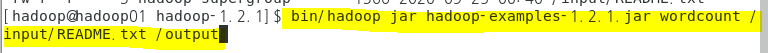

hadoop에서 mapreduce실행하기

-

../bin/hadoop jar jar파일명 Driver파일 input파일 output파일

-

Driver 파일 : main메소드가 있는 자바 Application

-

output 파일 : mapreduce처리결과가 저장될 파일

-

input파일, output파일 모두 hdfs에 저장될 path

-

-

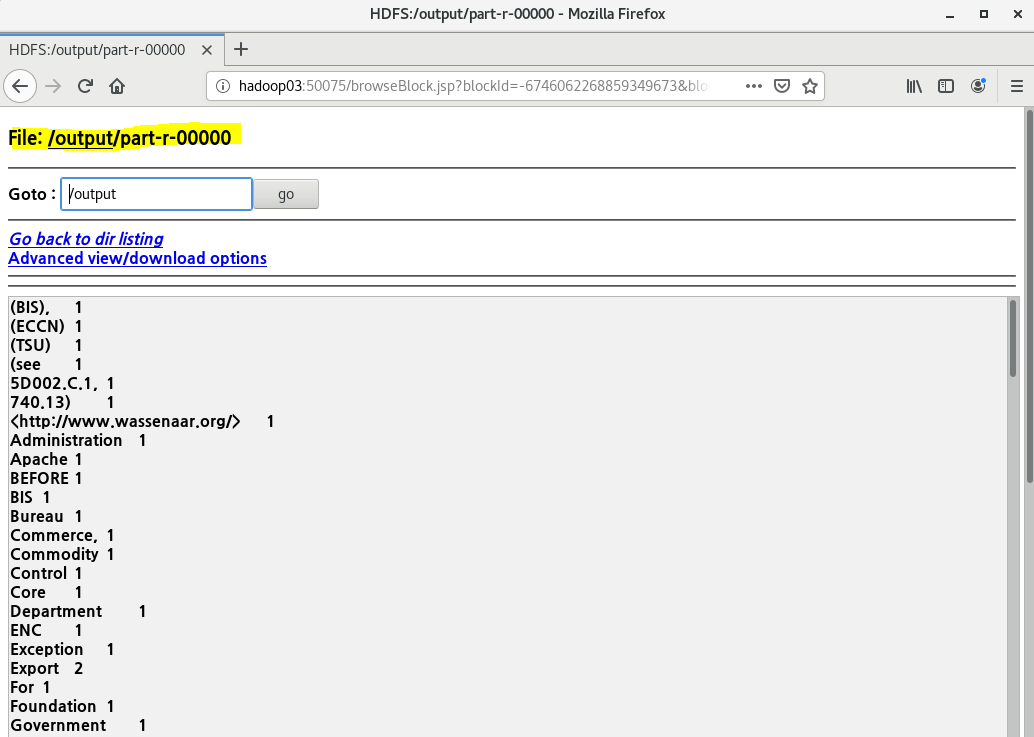

wordcount 실행

-

실행결과

jobtracker 관리자 페이지

'Hadoop' 카테고리의 다른 글

| 빅데이터 플랫폼 구축 #6 - MapReduce (0) | 2020.10.04 |

|---|---|

| 빅데이터 플랫폼 구축 #5 - HDFS 활용 (0) | 2020.10.04 |

| 빅데이터 플랫폼 구축 #3 - 가상머신 복제, 각 머신 연결 (0) | 2020.10.03 |

| 빅데이터 플랫폼 구축 #2 - CentOS 설치 (0) | 2020.10.02 |

| 빅데이터 플랫폼 구축 #1 - VMware 설치, 네트워크 설정 (0) | 2020.10.02 |

- Total

- Today

- Yesterday

- 하둡

- Disk System

- Spring

- vmware

- oracle

- Free space management

- springboot

- maven

- Flume

- Disk Scheduling

- jdbc

- SQL

- File Protection

- I/O Services of OS

- aop

- mapreduce

- 빅데이터 플랫폼

- gradle

- Variable allocation

- JSON

- Allocation methods

- SPARK

- Replacement Strategies

- hadoop

- Java

- linux

- 빅데이터

- I/O Mechanisms

- RAID Architecture

- HDFS

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |